مع تقدم عصر الإنترنت ، نقوم بإنشاء كمية لا يمكن فهمها من البيانات كل ثانية. لدرجة أننا أشرنا إليها ببساطة على أنها بيانات ضخمة. بطبيعة الحال ، تريد الشركات والمحللون فتح جميع الأنواع المختلفة من البيانات الضخمة للحصول على المعلومات المثيرة في الداخل.

لكنها ليست بهذه البساطة. تستفيد الأنواع المختلفة من أدوات البيانات الضخمة المتنوعة ولها تعقيدات مختلفة تصاحب العمل مع كل نقطة بيانات فردية مأخوذة من الأثير الهائل.

ما هي البيانات الضخمة؟

تشير البيانات الضخمة إلى الكم الهائل والمتزايد باستمرار من البيانات التي تمتلكها المنظمة والتي لا يمكن تحليلها باستخدام الطرق التقليدية.

غالبًا ما تكون البيانات الضخمة ، التي تشمل أنواع البيانات المنظمة وغير المنظمة ، هي المادة الخام للمؤسسات لتشغيل التحليلات واستخراج الرؤى التي يمكن أن تساعدهم في صياغة استراتيجيات أعمال أفضل. إنه أكثر من مجرد منتج ثانوي للعمليات والتطبيقات التكنولوجية. تعد البيانات الضخمة من أهم الأصول اليوم.

يمكن أن تتكون البيانات الضخمة من بيانات منظمة تقليدية أو بيانات غير منظمة أو شبه منظمة. من الأمثلة على البيانات الضخمة غير المهيكلة - والمتنامية باستمرار - البيانات التي ينشئها المستخدم على وسائل التواصل الاجتماعي. تتطلب معالجة مثل هذه البيانات نهجًا مختلفًا عن البيانات المنظمة إلى جانب الأدوات والتقنيات المتخصصة.

البيانات الضخمة هي نتيجة ثانوية للانفجار المعلوماتي اليوم. تساهم جميع مجالات العمل والحياة اليومية في تراكم البيانات الضخمة المزدهرة: البيع بالتجزئة والعقارات والسفر والسياحة والتمويل ووسائل التواصل الاجتماعي إلى التكنولوجيا ، كل جانب من جوانب حياتنا من عدد الخطوات التي نتخذها إلى تاريخنا المالي عبارة عن بيانات.

مع تزايد عدد الأشخاص الذين يستخدمون الإنترنت بشكل كبير ، لا تنام البيانات أبدًا.

خصائص البيانات الضخمة

يتم قبول العناصر الخمسة للبيانات الضخمة عالميًا:

- الحجم Volume

- السرعة Velocity

- التنوع Variety

- الموثوقية Veracity

- قيمةValue

1.الحجم Volume

إذا فكرنا في البيانات الضخمة على أنها هرم ، فإن الحجم سيشكل قاعدته العريضة. بدأ حجم البيانات التي تديرها الشركات في جميع أنحاء العالم في الارتفاع في حوالي عام 2012 عندما بدأت المنظمات في جمع أكثر من ثلاثة ملايين قطعة من البيانات كل يوم. منذ ذلك الحين ، يُقدر أن هذا الحجم يتضاعف كل 40 شهرًا ، وفقًا لأستاذ ماجستير إدارة الأعمال بجامعة أنطونيو دي نيبريجا.

2.السرعة Velocity

يشير مصطلح "السرعة" إلى السرعة التي يتم بها إنشاء البيانات.

لا يقتصر الأمر على حجم البيانات الضخمة التي يمكن أن تكون أصلًا: فمدى سرعة تدفقها ، أي سرعتها ، مهم أيضًا. كلما اقتربنا من الوقت الفعلي ، كان ذلك أفضل من حيث الميزة التنافسية للشركات التي تتطلع إلى استخراج رؤى قابلة للتنفيذ وقيمة منها.

مثال على ذلك هو ما إذا قررت شركة توصيل الطعام شراء حملة إعلانات جوجل على أساس بيانات مبيعاتها بعد 45 دقيقة من بدء حدث رياضي كبير. ستفقد نفس البيانات أهميتها بعد بضع ساعات.

تشمل التقنيات التي تقود هذه الحاجة إلى البيانات السريعة علامات RFID والقياس الذكي وأنواع مختلفة من أجهزة الاستشعار.

3.التنوع Variety

يشير التنوع إلى مجموعة المصادر التي يمكن للشركة من خلالها الحصول على البيانات الضخمة ومجموعة كبيرة من التنسيقات التي يمكن أن تظهر بها. وهذا يشمل أماكن مثل الهواتف الذكية والأجهزة الداخلية ومحادثات الوسائط الاجتماعية وبيانات مؤشر الأسهم وبيانات من المعاملات المالية.

يجب أن يكون المصدر وثيق الصلة بشكل خاص بطبيعة العمل التجاري الذي يتم جمع البيانات من أجله.

على سبيل المثال ، يجب ضبط شركة البيع بالتجزئة على ما يقوله المستخدمون على وسائل التواصل الاجتماعي حول خط الملابس الذي تم إطلاقه مؤخرًا. ستكون شركة التصنيع أقل قيمة مضمنة في متابعة وسائل التواصل الاجتماعي.

يمكن أن تمتد مجموعة متنوعة من البيانات لمساعدة المؤسسات على فهم ملفات تعريف العملاء وشخصياتهم. على سبيل المثال ، قد تجد الشركة أنه من المفيد معرفة ليس فقط عدد الأشخاص الذين يفتحون رسالتهم الإخبارية ، ولكن أيضًا لماذا قاموا بفتحها وتمييز خصائص الجمهور.

4.الصدق Veracity

يدعو الصدق إلى التشكيك في جودة البيانات ودقتها. البيانات النظيفة هي الأكثر موثوقية. يجب على المؤسسات الاتصال وتنظيف وتحويل بياناتها عبر الأنظمة من أجل الوثوق بها. إنهم بحاجة إلى تسلسلات هرمية وروابط بيانات متعددة للحفاظ على التحكم في بياناتهم.

5.القيمة Value

تكمن القيمة في قمة الهرم ، وهي القدرة على استخلاص رؤى تجارية قابلة للتطبيق من داخل سيل البيانات.

القيمة هي القدرة على التنبؤ بعدد الأعضاء الجدد الذين سينضمون إلى الموقع ، وعدد العملاء الذين سيجددون بوالص التأمين ، وعدد الطلبات المتوقعة ، وما إلى ذلك. تتمثل القيمة في معرفة من هم أفضل العملاء ومن سيخرجون من الخريطة في غضون أسابيع أو أشهر قليلة ، ولن يعودوا أبدًا.

تكتسب الشركات قيمة من خلال قدرتها على تحقيق الدخل من الرؤى التي توفرها البيانات الضخمة. يتعرفون على عملائهم بشكل أفضل ويستمرون في تقديم عروض أكثر صلة.

انواع البيانات الضخمة

1.البيانات المنظمة

يمكن تعريف البيانات المهيكلة بدقة على أنها البيانات الموجودة في حقل ثابت داخل سجل. إنه مرتبط بمخطط معين ، وبالتالي فإن جميع البيانات لها نفس مجموعة الخصائص. البيانات المهيكلة تسمى أيضًا البيانات العلائقية. يتم تقسيمها إلى جداول متعددة لتعزيز تكامل البيانات عن طريق إنشاء سجل واحد لتصوير كيان. يتم فرض العلاقات من خلال تطبيق قيود الجدول.

هناك حاجة إلى لغة الاستعلام الهيكلية (SQL) لتجميع البيانات معًا. من السهل إدخال البيانات المنظمة والاستعلام عنها وتحليلها. كل البيانات تتبع نفس التنسيق.

ومع ذلك ، فإن فرض بنية متسقة يعني أيضًا أن أي تغيير في البيانات يكون صعبًا للغاية حيث يجب تحديث كل سجل للالتزام بالهيكل الجديد. تتضمن أمثلة البيانات المنظمة الأرقام والتواريخ والسلاسل وما إلى ذلك. يمكن اعتبار بيانات الأعمال الخاصة بموقع التجارة الإلكترونية على أنها بيانات منظمة.

سلبيات البيانات المنظمة

- لا يمكن الاستفادة من البيانات المنظمة إلا في حالات الوظائف المحددة مسبقًا. هذا يعني أن البيانات المنظمة تتمتع بمرونة محدودة وهي مناسبة لبعض حالات الاستخدام المحددة فقط.

- يتم تخزين البيانات المنظمة في مستودع بيانات مع قيود صارمة ومخطط محدد. أي تغيير في المتطلبات يعني تحديث كل تلك البيانات المنظمة لتلبية الاحتياجات الجديدة. هذا عيب كبير من حيث إدارة الموارد والوقت.

2.البيانات شبه المنظمة

البيانات شبه المنظمة غير ملزمة بأي مخطط جامد لتخزين البيانات ومعالجتها. هذه البيانات ليست في التنسيق العلائقي وليست منظمة بدقة في صفوف وأعمدة مثل ذلك في جدول بيانات.

ومع ذلك ، هناك بعض الميزات مثل أزواج القيمة الرئيسية التي تساعد في تمييز الكيانات المختلفة عن بعضها البعض. نظرًا لأن البيانات شبه المنظمة لا تحتاج إلى لغة استعلام منظمة ، فإنها تسمى عادةً بيانات NoSQL. تُستخدم لغة تسلسل البيانات لتبادل البيانات شبه المهيكلة عبر الأنظمة التي قد تحتوي على بنية أساسية أساسية متنوعة.

يتم إنشاء البيانات بنص عادي بحيث يمكن استخدام أدوات تحرير النص المختلفة لرسم رؤى قيمة. نظرًا للتنسيق البسيط ، يمكن تنفيذ قارئات تسلسل البيانات على الأجهزة ذات موارد المعالجة وعرض النطاق الترددي المحدود.

لغات تسلسل البيانات

يستخدم مطورو البرامج لغات التسلسل لكتابة البيانات المستندة إلى الذاكرة في الملفات والعبور والتخزين والتحليل. لا يحتاج المرسل والمتلقي إلى معرفة النظام الآخر. طالما يتم استخدام نفس لغة التسلسل ، يمكن فهم البيانات من قبل كلا النظامين بشكل مريح. هناك ثلاث لغات تسلسلية مستخدمة في الغالب.

لغة XML

XML تعني لغة التوصيف الموسعة. إنها لغة ترميز نصية مصممة لتخزين البيانات ونقلها. يمكن العثور على موزعي XML في جميع منصات التطوير الشائعة تقريبًا. إنه إنسان ومقروء آليًا. يحتوي XML على معايير محددة للمخطط والتحويل والعرض. إنها ذاتية الوصف. فيما يلي مثال لتفاصيل المبرمج في XML.

<rec><name>Prashant Rao</name><sex>Male</sex><age>35</age></rec>

<rec><name>Seema R.</name><sex>Female</sex><age>41</age></rec>

<rec><name>Satish Mane</name><sex>Male</sex><age>29</age></rec>

<rec><name>Subrato Roy</name><sex>Male</sex><age>26</age></rec>

<rec><name>Jeremiah J.</name><sex>Male</sex><age>35</age></rec>يعبر XML عن البيانات باستخدام العلامات (النص داخل الأقواس الزاوية) لتشكيل البيانات (على سبيل المثال: الاسم الأول) والسمات (على سبيل المثال: النوع) لتمييز البيانات. ومع ذلك ، نظرًا لكونها لغة مطولة ومضخمة ، فقد اكتسبت التنسيقات الأخرى شعبية أكبر.

JSON

JSON (JavaScript Object Notation) هو تنسيق ملف خفيف الوزن ذو معيار مفتوح لتبادل البيانات. بيانات JSON سهلة للاستخدام ويستخدم هذا التنسيق نصًا يمكن قراءته بواسطة الإنسان / الجهاز لتخزين ونقل كائنات البيانات.

{

"firstName": "Jane",

"lastName": "Doe",

"codingPlatforms": [

{ "type": "Fav", "value": "Motaber" },

{ "type": "2ndFav", "value": "Code4Eva!" },

{ "type": "3rdFav", "value": "CodeisLife" }

]

}

هذا التنسيق ليس رسميًا مثل XML. إنه أشبه بنموذج زوج المفتاح / القيمة أكثر من تصوير البيانات الرسمي. Javascript لديه دعم يحمل في ثناياه عوامل لـ JSON. على الرغم من أن JSON تحظى بشعبية كبيرة بين مطوري الويب ، إلا أن الموظفين غير التقنيين يجدون صعوبة في العمل مع JSON نظرًا لاعتمادها الشديد على JavaScript والأحرف الهيكلية (الأقواس ، والفواصل ، وما إلى ذلك)

YAML

YAML هي لغة تسلسل بيانات سهلة الاستخدام. من الناحية المجازية ، فهي تعني YAML Ain't Markup Language. تم اعتماده من قبل معالجات تقنيين وغير تقنيين في جميع أنحاء العالم نظرًا لبساطته. يتم تحديد بنية البيانات من خلال فصل الأسطر والمسافة البادئة وتقليل الاعتماد على الأحرف الهيكلية. YAML شامل للغاية وشعبيته نتيجة لسهولة قراءته بين الإنسان والآلة.

يعد كتالوج المنتج المنظم بواسطة العلامات مثالاً على البيانات شبه المنظمة.

البيانات غير المهيكلة

البيانات الضخمة غير المنظمة هي نوع البيانات التي لا تلتزم بأي مخطط أو مجموعة قواعد محددة. ترتيبها عشوائي وعشوائي. يمكن اعتبار الصور ومقاطع الفيديو والمستندات النصية وملفات السجل بشكل عام بيانات غير منظمة.

على الرغم من أن البيانات الوصفية المصاحبة لصورة أو مقطع فيديو قد تكون شبه منظمة ، فإن البيانات الفعلية التي يتم التعامل معها غير منظمة.

أنظر أيضاً: ما هي الحوسبة السحابية cloud computing ؟

الفرق بين البيانات المهيكلة وشبه المهيكلة وغير المنظمة

| العوامل | البيانات المنضمة | البيانات الشبه منضمة | البيانات الغير منضمة |

|---|---|---|---|

| المرونة | إنها تابعة وأقل مرونة | إنها أكثر مرونة من البيانات المنظمة ولكنها أقل مرونة من البيانات غير المنظمة | إنه مرن بطبيعته ويوجد عدم وجود مخطط |

| ادارة العمليات التجارية | المعاملات الناضجة وتقنيات التزامن المختلفة | الصفقة مقتبسة من نظم إدارة قواعد البيانات (DBMS) لم تنضج | لا إدارة المعاملات ولا التزامن |

| أداء الاستعلام | يسمح الاستعلام المنظم بالانضمام المعقد | الاستعلامات عبر العقد المجهولة ممكنة | استعلام نصي فقط هو ممكن |

| التكنولوجيا | يعتمد على جدول قاعدة البيانات العلائقية | تعتمد على RDF و XML | هذا يعتمد على بيانات الشخصية والمكتبة |

البيانات الضخمة هي بالفعل ثورة في مجال تكنولوجيا المعلومات. يتزايد استخدام تحليلات البيانات كل عام. على الرغم من الطلب ، تفتقر المنظمات حاليًا إلى الخبراء.

لتقليل فجوة المواهب هذه ، تقدم العديد من معاهد التدريب دورات حول تحليلات البيانات الكبيرة والتي تساعدك على ترقية مجموعة المهارات اللازمة لإدارة وتحليل البيانات الضخمة.

إذا كنت حريصًا على تناول تحليلات البيانات كمهنة ، فسيكون الحصول على تدريب على البيانات الضخمة ميزة إضافية

كيف يتم معالجة البيانات الضخمة

تبدأ معالجة البيانات الضخمة بإعداد استراتيجية لتسخيرها. تتمثل الخطوة التالية في تحديد مصادرها ومواقعها وأنظمتها ومستخدميها ومالكيها وفهرستها وكيفية تدفقها. ثم إنشاء بنية تحتية لتخزين البيانات وإدارتها بحيث يمكن الوصول إليها بسهولة للتحليل ، وهي الخطوة الأخيرة لتسهيل عملية الاعتماد على البيانات اتخاذ القرار. هذا البروتوكول مفيد لإدارة مجموعات البيانات المهيكلة التقليدية وكذلك البيانات غير المهيكلة وشبه المنظمة.

عند تطوير استراتيجية إدارة البيانات الضخمة ، من الضروري مراعاة أهداف العمل الحالية والمستقبلية من نمو الأعمال التجارية بالإضافة إلى وجهة نظر التكنولوجيا ، والتعامل مع البيانات الضخمة تمامًا مثل أي أصول تجارية أخرى ذات قيمة.

يمكن تخزين البيانات إما في الموقع في مستودع بيانات تقليدي ، لكن حلول التخزين السحابية اكتسبت شعبية في السنوات الأخيرة. هذه أكثر اقتصادا وتوفر درجة معينة من المرونة.

عندما يتعلق الأمر بالمعالجة ، فإن أنظمة الحوسبة المتاحة اليوم تساوي السرعة والقوة وخفة الحركة اللازمة لتلبية متطلبات الوصول إلى أحجام البيانات الضخمة هذه. كما أن تكامل البيانات ، وضمان مراقبة الجودة ، وتوفير حوكمة البيانات وتجهيزها للأدوات التحليلية للقيام بعملهم هي أيضًا معايير ضرورية.

أنظر أيضاً:ما هي الالسحابة؟

أدوات لاستخراج أكبر قدر من البيانات الضخمة

البيانات الضخمة هي التي تغذي مساعي التحليلات المتقدمة في عصرنا ، مثل الذكاء الاصطناعي. كلما زادت كفاءة استخدام الشركة لبياناتها التي تم جمعها ، زادت إمكانية استخلاصها منها. يعد الاستثمار في البرامج التي يمكنها إدارة وتحليل كميات ضخمة من البيانات ، لا سيما في الوقت الفعلي ، خطوة حيوية لإدارة البيانات الضخمة.

MapReduce و BigTable و Hadoop: عند تخزين كميات كبيرة من البيانات ، وتحديد طرق أفضل أو أكثر كفاءة لإجراء أنشطة الأعمال ، يتم استغلال أدوات مثل Hadoop والتحليلات المستندة إلى السحابة. هذه تساعد في تحسين العمليات لتقديم مزايا التكلفة.

علاوة على ذلك ، تساعد السرعة العالية للأدوات مثل Hadoop إلى جانب التحليلات في الذاكرة في تحديد الموارد غير المستغلة ، أي مصادر البيانات الأحدث للتحليل. تعد سرعة التقاط البيانات وتحليلها رصيدًا كبيرًا للشركات لاتخاذ قرارات سريعة.

تحتاج التحديات المعقدة إلى حلول ذكية. تحتاج الأنظمة الأساسية إلى تمكين المؤسسات من خلال واجهات سهلة الاستخدام وبسيطة تضمن إمكانية استخدامها حتى لأقل ذكاء في تكنولوجيا المعلومات.

يجب أن تكون المنصة أيضًا قادرة على الاستفادة من النطاق الكامل للبيانات الضخمة ، مما ينتج عنه تحليلات دقيقة في الوقت الفعلي. القدرة على التعامل مع مجموعات تيرابايت متعددة من مجموعات البيانات من مصادر متنوعة وتحويلها بنجاح إلى لوحات معلومات توفر رؤى مفيدة وتحليلات لسير العمل تجعل النظام ناجحًا.

تحليلات البيانات الضخمة: رؤى

- تؤدي تحليلات البيانات الضخمة إلى فهم أعمق لظروف السوق الحالية وسلوك الشراء لدى العملاء وشعبية المنتج وما إلى ذلك ، لتحسين التخطيط التصنيعي أو الشراء.

- وبالمثل ، تساعد البيانات الضخمة الأعمال التجارية على تكبير ما يحبه عملاؤه ، وما هي الخصائص الديمغرافية التي ينتمي إليها عملاؤهم الذين يدفعون ، ثم التوصل إلى طرق لمكافأة ولائهم وتعزيزه للاحتفاظ بعملائهم على المدى الطويل.

- الحفاظ على العملاء سعداء أمر بالغ الأهمية لاستمرارية العمل. تقطع الرؤى التي توفرها البيانات الضخمة شوطًا طويلاً في إدارة التوقعات وتصميم حملات تسويقية لا تُنسى وفعالة لمختلف شخصيات العملاء.

- يمكن أن تكون تحليلات البيانات الضخمة أيضًا مقياسًا للمشاعر ، يقيس شعور المستهلكين تجاه علامتك التجارية أو خدمتك أو منتجك. يمكن أن يكون هذا مساعدة كبيرة في إدارة صورة العلامة التجارية. ويمكن أن تساعد رؤى البيانات الضخمة في تحسين الرؤية والشهرة عبر الإنترنت والحفاظ على التقييمات العالية.

- تساعد الرؤى التي توفرها تحليلات البيانات الضخمة الشركات على ابتكار منتجاتها وإعادة تطويرها باستمرار للبقاء في صدارة المنافسة. فهي تساعد في تحديد السبب الجذري للفشل والمشكلات والعيوب.

- تساعد البيانات الضخمة في تحديد الأنماط وحساب محافظ المخاطر واعتراض السلوك الاحتيالي قبل حدوث ضرر جسيم.

الفوائد طويلة المدى المستمدة من معالجة البيانات الضخمة

بمجرد استثمار المؤسسات للوقت والموارد في البنية التحتية اللازمة لمعالجة البيانات الضخمة ، يمكنها التطلع إلى جني الفوائد التالية:

- تحسين الموارد وتخطيط المخزون

- إدارة أفضل للأصول

- فهم أكثر سهولة لملفات تعريف العملاء

- تحسين العلاقات بين العملاء والموردين والموردين

- أوقات تسليم الطلبات أقصر

- تكامل أفضل عبر سلسلة التوريد بأكملها

- تخطيط استراتيجي أكثر فعالية

- وقت رد فعل أقصر لمعالجة مشكلات سلسلة التوريد

- خدمة عملاء محسّنة وتحول أسرع

المهارات المطلوبة لتصبح متخصصًا في البيانات الضخمة

- المهارات التحليلية: هذه المهارات ضرورية لفهم البيانات ، وتحديد البيانات ذات الصلة عند إنشاء التقارير والبحث عن حلول.

- الإبداع: يجب أن تكون لديك القدرة على إنشاء طرق جديدة لجمع وتفسير وتحليل إستراتيجية البيانات.

- الرياضيات والمهارات الإحصائية: يعد "الطحن الرقمي" الجيد القديم ضروريًا أيضًا ، سواء كان ذلك في علم البيانات أو تحليلات البيانات أو البيانات الضخمة.

- علوم الكمبيوتر: تعد أجهزة الكمبيوتر العمود الفقري لكل استراتيجية بيانات. سيكون للمبرمجين حاجة مستمرة لابتكار خوارزميات لمعالجة البيانات وتحويلها إلى رؤى.

- مهارات العمل: سيحتاج متخصصو البيانات الضخمة إلى فهم أهداف العمل الموضوعة ، بالإضافة إلى العمليات الأساسية التي تدفع نمو الأعمال وأرباحها.

فرص العمل بعد الحصول على ماجيستر البيانات الضخمة

يعد محترفو البيانات الضخمة من بين أكثر الشركات طلبًا من قبل الشركات. سيكونون أيضًا الأكثر طلبًا في المستقبل. تركز المنظمات على جمع البيانات وتحليل معلومات العملاء وكذلك تفسير البيانات الضخمة.

تتزايد الحاجة إلى ملفات تعريف تحليلية في مختلف قطاعات الأعمال في الشركات. لذلك ، فهي تتطلب المزيد من تحليل البيانات وتطوير الذكاء الاصطناعي. ولهذا السبب ، فإن مهن البيانات الضخمة أدناه هي المناصب في مرمى البصر لحاملي درجة الماجستير في البيانات الضخمة.

مدير البيانات

مدير البيانات الرئيسي (CDO) هو مدير البيانات على أعلى المستويات التكنولوجية والتجارية والأمنية. وهي مسؤولة عن إدارة البيانات كأصل عمل. تشمل وظائفه إستراتيجية عمليات البيانات وحوكمة البيانات.

محلل رقمي

وتتمثل مهمتها في إعطاء معنى للبيانات التي يتم جمعها من خلال أدوات القياس المختلفة عبر الإنترنت. من خلال التقارير والعروض التقديمية ولوحات المعلومات ، يقدم توصيات إستراتيجية لمواءمة أهداف العمل مع تلك التي تمكن من قياسها عبر الإنترنت. كما أنه يطور مقترحات التحسين للمواقع على الإنترنت ويصمم إستراتيجيات القياس. المعرفة المتعمقة للتسويق واستراتيجية العمل ومهارات الاتصال ضرورية له حتى يكون لديه القدرة على الإبلاغ عن النتائج.

محلل بيانات

يهدف إلى فهم البيانات التي تم جمعها من مشاريع تكامل البيانات الضخمة وتحويل هذه البيانات إلى معلومات مفيدة وذات صلة للأعمال. وهو مسؤول عن إدارة البيانات والبنية التحتية وإدارة المعرفة وخطط تحليل البيانات الرائدة في بيئات مثل وسائل التواصل الاجتماعي. مطلوب معرفة البرمجة ومكتبات تحليل البيانات وأدوات الذكاء الاصطناعي والتقارير.

علماء البيانات

ينشئ عالم البيانات خوارزميات التعلم الآلي التي ستكون قادرة على أتمتة النماذج التنبؤية ، أي للتنبؤ بالمعلومات الجديدة وتصنيفها تلقائيًا. للقيام بذلك ، لديه مهارات في الإحصاء والرياضيات التطبيقية.

مهندس البيانات

هذا المحترف مسؤول عن تصميم وإدارة كميات كبيرة من البيانات. يقوم بإعداد قواعد البيانات بطريقة تتماشى مع أهداف العمل. وبالتالي ، يمكن للمهنيين الآخرين إجراء تحليل البيانات ذات الصلة.

محلل ذكاء الأعمال

يستخدم هذا المحترف أساليب وتقنيات تحليلية لفهم العميل وتأثيرها على الأعمال. يحدد فرص تحقيق الدخل من خلال تحليل البيانات. للقيام بذلك ، قام بإنشاء استراتيجيات تركز على علاقة العميل من تحليل السلوكيات الناتجة عن تقاطع بيانات CRM الداخلية مع البيانات الخارجية الناتجة عن التفاعل الاجتماعي. ومع ذلك ، يجب أن يكون حاصلًا على شهادة في الهندسة ، في الإحصاء أو الرياضيات بالإضافة إلى مهارات في إدارة قواعد البيانات ولغات البرمجة (مثل Python).

خبير الأخلاق وخصوصية البيانات

هذا هو أحد الملفات الشخصية التي سيتم طلبها في المستقبل. في الواقع ، سوف يتكيف بسرعة مع جميع التغييرات القادمة في بيئة معقدة وغامضة للغاية.

فهم تاريخ البيانات المنضمة

كيف بدأ كل شيء (الأربعينيات)

منذ زمن بعيد ، في ديسمبر 1945 ، تم الانتهاء من أول كمبيوتر رقمي إلكتروني متعدد الأغراض. كان يسمى ENIAC (التكامل العددي الإلكتروني والكمبيوتر). لقد كانت بداية حقبة أنتجنا فيها أجهزة كمبيوتر لفئات متعددة من المشكلات بدلاً من البناء المخصص لكل حالة استخدام معينة.

لمقارنة الأداء ، كان لدى ENIAC ساعة بحد أقصى 5 كيلو هرتز على نواة واحدة ، في حين أن أحدث شريحة في iPhone (Apple A13) لديها 2.66 جيجا هرتز على 6 نوى. يُترجم هذا تقريبًا إلى حوالي أربعة ملايين مرة أكثر من الدورات في الثانية ، بالإضافة إلى التحسينات في مقدار العمل الذي يمكن إنجازه في إحدى تلك الدورات.

من الناحية التاريخية ، مررنا بدورات من التوسع في أحدث التطورات في الأجهزة لإطلاق العنان لقدرات هندسة البرمجيات الجديدة. كان هناك نمط من المرونة المتزايدة مع طلب المزيد من المسؤولية من المهندسين. هناك رغبة حتمية في تقليل العبء الإضافي الذي يتحمله المهندسون مع توفير نفس المرونة. يتم تمكين هذه المرونة من خلال تنفيذ أفضل الممارسات التي يتم إثارة السخرية منها لأننا نفهم الأنماط التي تعمل ضمن تجريد معين.

تطور البيانات (بين الستينيات والتسعينيات)

كانت الخوادم تاريخيًا باهظة الثمن مع محدودية سعة التخزين والذاكرة وإمكانيات الحوسبة لحل المشكلات التي أردنا حلها دون بذل جهد كبير من قبل المبرمجين مثل إدارة الذاكرة. على النقيض من ذلك ، لدينا الآن لغات مع آلية لجمع القمامة للتعامل مع هذا الأمر من أجلنا.

هذا هو السبب في استخدام C و C ++ و FORTRAN كثيرًا واستمرار استخدامها لحالات الاستخدام عالية الأداء حيث نحاول تحقيق أكبر قدر ممكن من الكفاءة والقيمة من النظام. حتى اليوم ، تستدعي معظم تحليلات البيانات وأطر عمل التعلم الآلي في Python لغة C لضمان الأداء وكشف واجهة برمجة التطبيقات للمبرمج فقط.

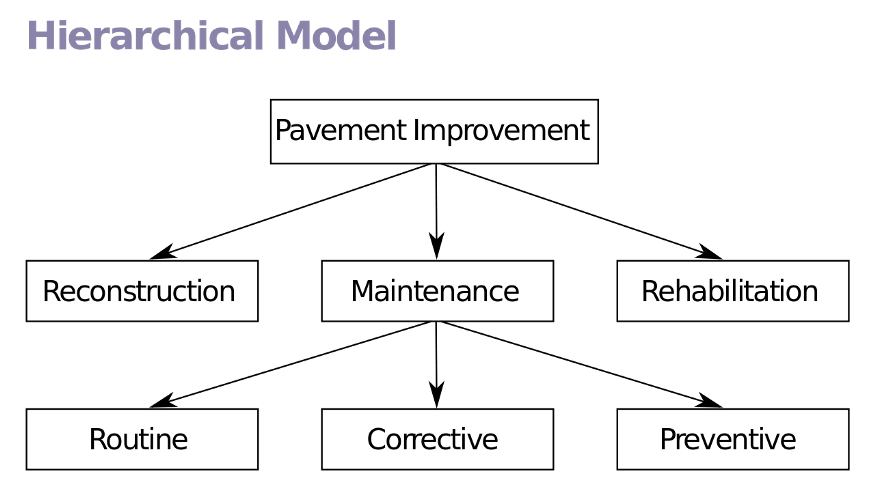

لاستخراج أكبر قدر ممكن من القيمة من أنظمة تنظيم البيانات ، استثمرت شركات مثل IBM بكثافة في نماذج معينة لتخزين البيانات واستعادتها والعمل معها. لدينا نموذج البيانات الهرمي الذي كان سائدًا للغاية خلال أيام المعدن الكبير في الكمبيوتر الرئيسي من هذا العمل. من خلال إنشاء نموذج قياسي ، قاموا بتقليل مقدار الجهد الذهني المطلوب لبدء المشروع وزيادة المعرفة التي يمكن مشاركتها بين المشاريع.

النموذج الهرمي

نجحت الحواسيب الكبيرة في حل مشاكل اليوم ولكنها كانت باهظة الثمن ، لذلك كانت الشركات الكبرى فقط مثل البنوك قادرة على الاستفادة منها بشكل فعال. لقد كانوا فعالين للغاية في اجتياز الهياكل الشبيهة بالأشجار ، لكنهم فرضوا علاقة صارمة للغاية بين شخص وآخر قد يكون من الصعب التعبير عنها للمبرمج وجعل تطبيقاتهم صعبة التغيير.

في وقت لاحق ، تم إنشاء النموذج العلائقي ، والذي يدعم معظم قواعد البيانات لدينا اليوم. في النموذج العلائقي ، يتم تمثيل البيانات كمجموعات من المجموعات (الجداول) مع العلاقات بينها. العلاقة النموذجية هي مفتاح خارجي يشير إلى أن البيانات الموجودة في جدولين يجب أن تكون مرتبطة ببعضها البعض. لا يمكنك الحصول على درجة بدون ربط الطالب بها ، ولا يمكنك الحصول على فصل بدون مدرس لتعليم الدرس.

لغات التفاعل مع البيانات

نظرًا للهيكل المطبق على البيانات ، يمكننا تحديد لغة قياسية للتفاعل مع البيانات في هذا النموذج. أنشأ المخترع الأصلي للنموذج العلائقي أيضًا لغة الاستعلام الهيكلية (SQL) ، وهي المعيار الواقعي للوصول إلى البيانات اليوم. هذا لأن SQL سهلة القراءة ، مع كونها قوية للغاية أيضًا. تكون لغة SQL كاملة عندما يكون لدى النظام إمكانيات لوظائف التكرار والنافذة.

تورينغ الاكتمال يترجم تقريبًا إلى أن اللغة يمكن أن تحل أي مشكلة حسابية مع إعطاء الوقت الكافي. هذه خاصية نظرية ممتازة لـ SQL ، ولكنها لا تعني دائمًا أنها أفضل أداة لكل وظيفة. هذا هو السبب في أننا نستخدم SQL للوصول إلى البيانات واستردادها ، ولكن مع الاستفادة من Python واللغات الأخرى لإجراء تحليلات متقدمة ضد البيانات.

أصدرت Oracle أول منتج لقواعد البيانات العلائقية في عام 1979. وتسمى هذه الأنظمة أنظمة إدارة قواعد البيانات العلائقية (RDBMS). منذ ذلك الحين ، تم إطلاق العشرات من أنظمة RDBMS التجارية والمفتوحة المصدر بكميات مختلفة من الضجة.

أدت هذه المساهمات الأولية إلى المصدر المفتوح إلى أن تكون Apache Software Foundation هي المكان الفعلي للأدوات في مساحة "البيانات الكبيرة" مع ترخيصها المسموح به الذي يتيح الأنشطة التجارية عند الاستفادة من شفرة المصدر الأساسية للمكتبات.

تعمل هذه الأنظمة بشكل جيد للغاية لإدارة والوصول إلى البيانات التي تستفيد من هياكل البيانات الموحدة ؛ ومع ذلك ، مع نمو أحجام البيانات ، يبدأ أداؤها في الانحناء تحت ضغط الحمل. لدينا العديد من التحسينات التي يمكننا الاستفادة منها لتقليل الضغط على الأنظمة ، مثل الفهرسة وقراءة النسخ المتماثلة والمزيد.

قد يكون موضوع تحسين أداء RDBMS عدة منشورات وكتب مدونة أخرى وهو خارج نطاق هذه المناقشة.

العالم المتصل وجميع بياناته (التسعينيات)

قبل أن تكون أجهزة الكمبيوتر عنصرًا أساسيًا في كل منزل ، وكانت الهواتف المحمولة في جيوب الجميع ، كان الاتصال والبيانات المحيطة بهذا الاتصال أقل بشكل ملحوظ. تم تمكين التتبع في كل موقع ويب تقريبًا تقريبًا لفهم تجربة المستخدم بشكل أفضل وتقديم نتائج مخصصة لعملائهم.

جاء هذا الانفجار في جمع البيانات من القدرة على أتمتة عملية الجمع حيث كان على المستخدمين تاريخيًا تقديم ملاحظات في شكل استطلاعات رأي ومكالمات هاتفية وما إلى ذلك. اليوم ، يتم تتبعنا من خلال أنشطتنا ، وتتحدث أفعالنا بصوت أعلى من أفكارنا. لم يعد Netflix يسمح لك بترتيب الأفلام أو تسجيلها ، حيث اكتشفوا أن الإشارة لم تكن تعطي أي استفادة من النظام البيئي.

يظهر استخدام مصطلح "البيانات الضخمة" اليوم يلي :

2007

تقدم Wired مفهوم البيانات الضخمة إلى الجماهير بمقالها The End of Theory: The Data Deluge يجعل النموذج العلمي قديمًا.

2008

تعالج الخوادم في العالم 9.57 زيتابايت (9.57 تريليون غيغابايت) من المعلومات - أي ما يعادل 12 غيغابايت من المعلومات لكل شخص يوميًا) ، وفقًا لـ How Much Information؟ تقرير 2010. في الإنتاج الدولي ونشر المعلومات ، تشير التقديرات إلى أنه تم إنتاج 14.7 إكسابايت من المعلومات الجديدة هذا العام.

2009

تقوم الشركة الأمريكية المتوسطة التي يعمل بها أكثر من 1000 موظف بتخزين أكثر من 200 تيرابايت من البيانات وفقًا لتقرير البيانات الكبيرة: الحدود التالية للابتكار والمنافسة والإنتاجية من معهد ماكينزي العالمي.

2010

أخبر إريك شميدت ، الرئيس التنفيذي لشركة جوجل، مؤتمرًا أنه يتم الآن إنشاء قدر كبير من البيانات كل يومين ، كما تم إنشاؤه منذ بداية الحضارة الإنسانية حتى عام 2003.

2011

ينص تقرير McKinsey على أنه بحلول عام 2018 ، ستواجه الولايات المتحدة عجزًا يتراوح بين 140.000 و 190.000 عالم بيانات محترف ، وينص على أنه يجب حل المشكلات بما في ذلك الخصوصية والأمن والملكية الفكرية قبل تحقيق القيمة الكاملة للبيانات الضخمة.

2014

ظهور الأجهزة المحمولة - لأول مرة ، يستخدم عدد أكبر من الأشخاص الأجهزة المحمولة للوصول إلى البيانات الرقمية ، أكثر من أجهزة الكمبيوتر المكتبية أو المنزلية. أفاد 88٪ من رجال الأعمال الذين شملهم الاستطلاع من قبل GE يعملون مع Accenture أن تحليلات البيانات الضخمة تمثل أولوية قصوى لأعمالهم.

خلاصة

- تعريف البيانات الضخمة: تعني البيانات الضخمة بيانات ضخمة الحجم. البيانات الضخمة هي مصطلح يستخدم لوصف مجموعة من البيانات الضخمة في الحجم والتي تتزايد باطراد مع مرور الوقت.

- تتضمن أمثلة تحليلات البيانات الضخمة البورصات ومواقع التواصل الاجتماعي والمحركات النفاثة وما إلى ذلك.

- يمكن أن تكون البيانات الضخمة 1) منظمة ، 2) غير منظمة ، 3) شبه منظمة

- الحجم والتنوع والسرعة والتغير هي خصائص قليلة للبيانات الضخمة

- خدمة العملاء المحسّنة ، والكفاءة التشغيلية الأفضل ، واتخاذ القرارات بشكل أفضل هي مزايا قليلة للبيانات الضخمة

تمهد البيانات الضخمة الطريق فعليًا لأي نوع من الرؤى التي يمكن أن تبحث عنها مؤسسة ما ، سواء كانت تحليلات إرشادية أو وصفية أو تشخيصية أو تنبؤية. إن عالم تحليلات البيانات الضخمة مبني على أكتاف العمالقة: إن إمكانات جمع البيانات وتحليلها معروفة منذ عقود ، إن لم يكن لقرون.

إذا كنت تختار حلاً ، فإن أنواع تحليلات البيانات الضخمة التي تعمل بها هي شيء تحتاج إلى التفكير فيه. لا تعرف من أين تبدأ في مغامرتك؟ يمكن أن تبدأ دورتنا التدريبية المكثفة حول تحليلات البيانات الضخمة في توجيهك في الاتجاه الصحيح. ألست متأكدًا مما تبحث عنه أيضًا في منتج البيانات الضخمة؟

توفر مقالة الميزات والمتطلبات الخاصة بنا نظرة ثاقبة حول ما يجب البحث عنه وتصنف بطاقة أداء الأداة القابلة للتخصيص المنتجات في مجالات مثل النص والمحتوى والإحصاءات ووسائل التواصل الاجتماعي والتحليلات المكانية.

الأسئلة الشائعة

ما هي البيانات الضخمة ؟

البيانات الضخمة هي أصول معلوماتية كبيرة الحجم وعالية السرعة و/أو عالية التنوع تتطلب أشكالًا مبتكرة وفعالة من حيث التكلفة لمعالجة المعلومات التي تتيح تحسين الرؤية واتخاذ القرار وأتمتة العمليات.

ما هي أنواعه البيانات الضخمة ؟

يتم تصنيف البيانات الضخمة بثلاث طرق: البيانات المنظمة. البيانات غير المهيكلة. البيانات شبه المنظمة.

ما هي المكونات الأربعة للبيانات الضخمة؟

يقسم علماء البيانات في شركة IBM البيانات الضخمة إلى أربعة أبعاد: الحجم والتنوع والسرعة والصدق.

ما هي أنواع البيانات الكمية؟

هناك ثلاثة أنواع من البيانات الكمية ، وكل منها يحمل معلومات قيمة: بيانات منفصلة ، ومستمرة ، وفاصلة (بالمقارنة مع النسبة).