في نفس اليوم الذي رأيت فيه نتائج الذكاء الاصطناعي في محركات البحث، شعرت بالقلق بشأن عملي في تحسين محركات البحث (SEO). كان الأمر مقلقًا عندما أدركت أنني أستخدم نفس النتائج التي تقدم إجابات سريعة، ثم أترك محرك البحث لأواصل حياتي. توقفت لحظة وسألت نفسي: إذا كنت أعتمد على هذه النتائج، فلا بد أن الآخرين يفعلون الشيء نفسه، مما يعني أن المواقع والجهود المبذولة عليها قد تتعرض للخطر.

لكنني حاولت تهدئة نفسي وقررت أن أواصل العمل بجد لتحسين المواقع لتظهر في الصفحة الأولى. كنت أعتقد أن الجمهور سيظل مهتمًا بالمحتوى الفريد الذي نقدمه. ومع ذلك، لاحظت أن جهودي تؤتي ثمارها في زيادة مرات الظهور، لكن معدل النقرات كان يرتفع ببطء أو يبقى ثابتًا! لم أفهم السبب، هل كانت العناوين غير جذابة؟ أم أن الأوصاف لم تكن كافية لجذب انتباه الناس؟ حتى جاءني الجواب.

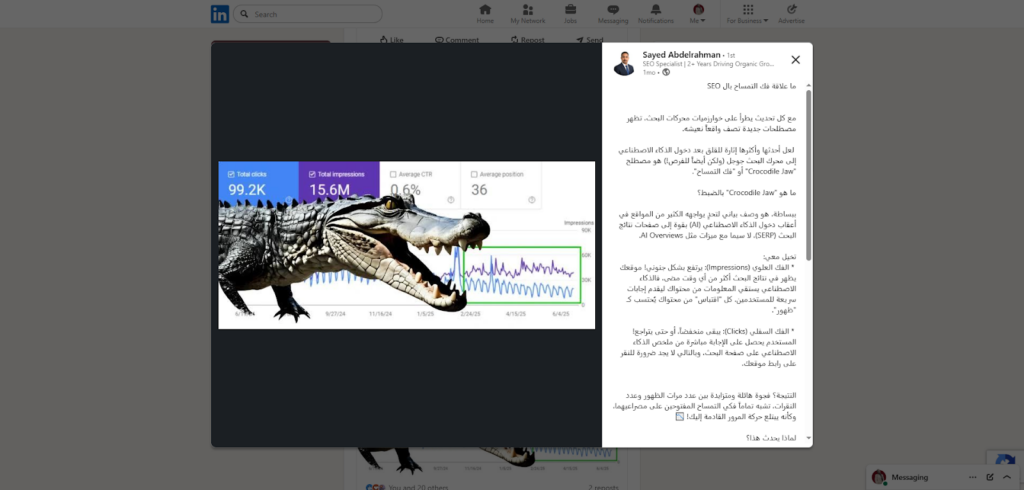

في يوم من الأيام، كنت أتصفح آخر الأخبار على موقع لينكد إن، وصادفت منشورًا لأحد الزملاء البارزين في مجال تحسين محركات البحث. كان يتحدث عن تحديث جديد يسمى "فك التمساح". تذكرت المخطط البياني الذي أراه في جوجل سيرش كونسول، حيث يرتفع الظهور بينما تنخفض النقرات! بالفعل، كان الأمر يشبه فك التمساح!

(صورة من المنشور وشكل توضيحي لفك التمساح المقصود في التحديث)

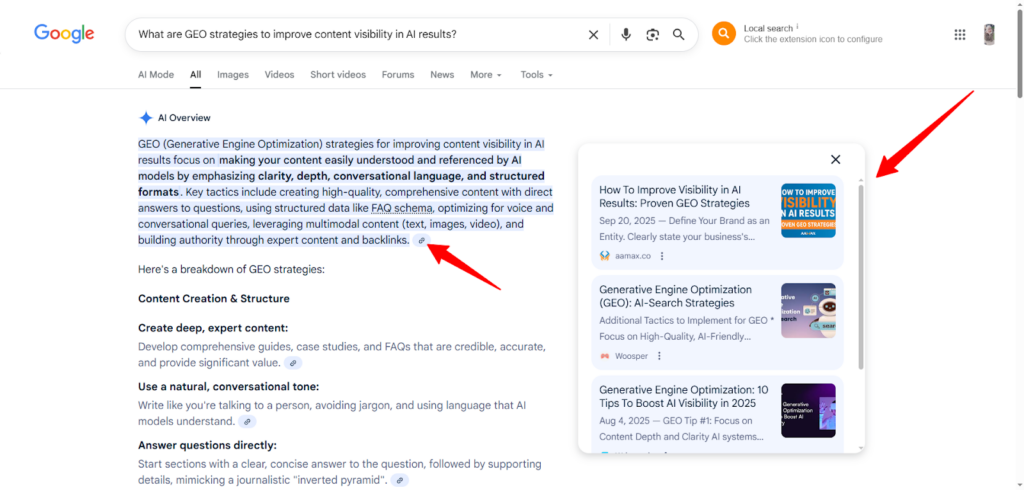

لم يعد من الأمر بدٌّ.. يجب علي أن أفهم كيف يعمل الذكاء الاصطناعي وعلى ما يعتمد في توليد الإجابات واستخلاصها وتثبيتها في أول الصفحة، وبالأخص عندما رأيت أنه يضع روابط المصادر كرابط للاستزادة بجانب المحتوى المولَّد، وقلت هذه هي فرصتي، يجب أن أتعلم كيف أزيد فرصة ظهور محتواي وصفحات موقعي في الظهور على نتائج الذكاء الاصطناعي AI.

ما هو ال GEO

شعرت بالراحة عندما عرفت أن GEO (Generative Engine Optimization) التي تعني تحسين محتوى نتائج الذكاء الاصطناعي، هي استراتيجيات، نعم ليس الأمر عشوائيًا، بل هي تقنيات واستراتيجيات مصممة خصيصًا لتحسين المحتوى ليتناسب مع نماذج الذكاء الاصطناعي المستخدمة في محركات البحث. تهدف هذه الاستراتيجيات إلى تزويد المحركات بالمعلومات الضرورية لعرض محتواك كإجابة مباشرة ومفيدة لاستفسارات المستخدمين.

حينها علمت أن يمكنني تعلم الحرفة لكي أنال التصدر من جديد!

ما هي استراتيجيات GEO تحسين ظهور المحتوى على نتائج AI

بعد أن تعمل على تحسين ظهور موقعك الإلكتروني لمحركات البحث في العموم، من تحسين واجهة المستخدم والتنقل وسرعة التحميل والتأكد من قابلية الموقع للعرض على كل الأجهزة والتأكد من مطابقة المحتوى لمعايير محركات البحث وما إلى ذلك من ممارسات ال SEO، ننتقل لاستراتيجيات متقدمة للسيطرة على نتائج الذكاء الاصطناعي أيضًا، وهي:

كن أنت المصدر بدلًا منهم

لا تتوقع أن الذكاء الاصطناعي يؤلف المحتوى الذي يعرضه في نتائجه، فهو عاجز عن ذلك، بل هو يقتبسه من المواقع الجديرة بالاقتباس، ويستشهد بروابط هذه الصفحات جوار النص المعروض.

هذه المصادر التي يستشهد بها الذكاء الاصطناعي هي صفحات مواقع منافسيك! فيجب أن تملأ فجوة الاستشهاد هذه وتكن أن المصدر بدلًا منهم.

سوف أقص عليك تجربتي القصيرة في هذه النقطة بالتحديد..

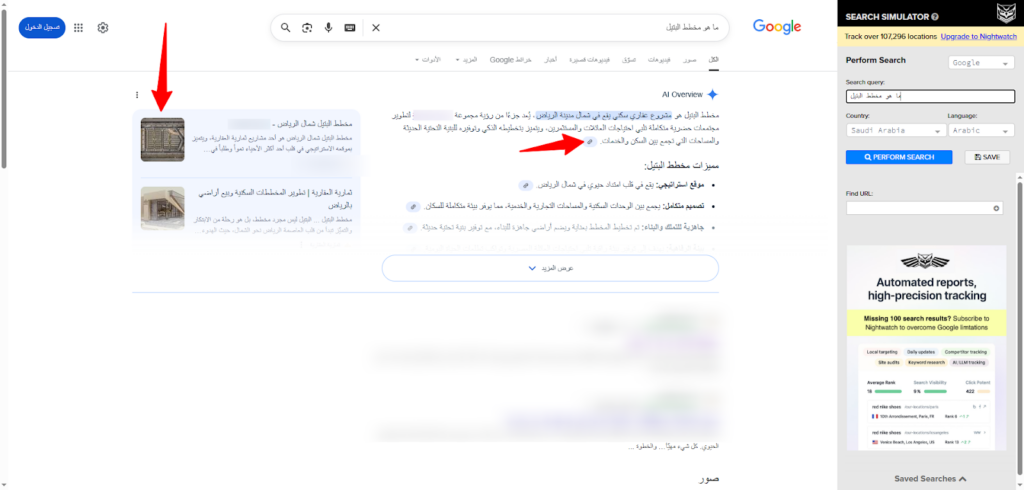

استلمت أحد المواقع الإلكترونية الضعيفة عديمة الظهور على محركات البحث، وبعد العمل على تحسين الموقع من كل الجهات، وجدت أن نتائج الذكاء الاصطناعي تفوقني، فبدلًا من أواصل منافستها قررت أن أتعاون معها، فكيف فعلت؟

قررت أن أكون أنا المصدر، أنا صاحبة علامة الدبوس التي تجاور المحتوى، حتى إن أراد المستخدم الاستزادة لم يجد أفضل من المصدر المستشهد به لكي يتزود منه.

ولكن كيف تملأ فجوات الاستشهاد؟ (Citation Gaps)

هل أخبرك بما فعلت أنا؟ حسنًا

موقع ضعيف مثل موقعي، كيف سيكسب ثقة الذكاء الاصطناعي لكي يستشهد به فيما بعد؟ بدأت أولًا بالتركيز على المحتويات الضعيفة التي لا يغطيها أغلب المنافسين، وعملت على دعمها ودعم كلماتها المفتاحية بقوة، فلن يجد ال AI أفضل مني يسشتهد به، ومرة تلو الآخرى أعطيته انطباعًا إيجابيًا عني وعن التزامي وموثوقيتي، حتى بات يراني ويرى محتواي ذو الجهد المبذول.

هل ترى المصادر على اليسار ورابط الاستشهاد جوار المحتوى، إنه للموقع الذي عملت عليه كما قلت لك، ظهر في كلمة مهمة ولكن محتواها الذي يقصده الجمهور ضعيف، فاجتهدت أنا في سد الفجوة، وقد كانت النتيجة.

والآن، ما رأيك أن أخبرك ببعض النصائح الأخرى التي تساعدك في سد فجوات الاستشهاد لتكن أنت المصدر لا غيرك؟

ابحث عن الاستشهادات المفقودة وقيمها، هل نتائج الذكاء الاصطناعي هل تتمكن من صناعة محتوى ينافسها أو يقدم قيمة مضافة لإضافتك معهم؟ إن وجدت أنك تقدم قيمة فريدة، حاول التواصل مع الكتاب أو الناشرين واعرض عليهم قيمتك واطلب منهم إضافتك في في محتواهم.

ولكن كيف إن كان صاحب المقال هو منافس لن يوافق على ذكر موقعك، يمكنك حينها اللعب بالكلمات المفتاحية المهمة والإحصائيات غير المذكورة ودراسات الحالة التي تدعم محتواك والتي ستجبر الذكاء الاصطناعي على ضمك إلى القائمة لأنك قدمت شيء لا يقدمه غيرك.

شارك في النقاشات المهمة

هل تلاحظ أن الذكاء الاصطناعي يولد إجابات من نقاشات على مواقع كبيرة مثل Reddit أو LinkedIn أو نقاشات مجتمعات مشاركة التجارب؟ حسنًا عليك بالانخراط بينهم والمشاركة في حواراتهم لتكن جزء منها.

أضف حساب علامتك التجارية على هذه المجتمعات وشارك في النقاشات مشاركة دورية بناءة بهدف الدعم والإفادة قبل الظهور، ولا شك أنك ستحصل على جمهور داعم وثقة من الجميع ومعهم الذكاء الاصطناعي.

ركز في هذه النقاشات على إضافة معلومات قيمة يبحث عنها الجميع وانفرد بالإجابة وبالدليل وبالتوضيحات والشروحات وذكر المراجع الموثوقة.

اختر أكثر المواضيع استشهادًا

من خلال عملي وتجربتي الحقيقية، وجدت أن الذكاء الاصطناعي لا يتدخل بالإجابة عن كل الأسئلة وكلمات البحث، هناك موضوعات يتدخل فيها وجوانب أخرى من نفس الموضوعات لا يجب عنها. اختر أنت أكثر الموضوعات استشهادًا وبروزًا في نتائج الذكاء الاصطناعي وأكتب عنها محتوى وافي يجيب عن أسئلة الناس الشائعة وغير الشائعة بأسلوب واضح ومباشر ومنهجي لكي يتمكن ال AI من فهمه واقتباسه.

حدث محتواك باستمرار

لا يكفي أن تحسن محتواك جملة واحدة وتتركه يلقى مصيره، بل يجب أن تحسن فيه بصفة دورية. كأن تضيف دراسات حالة، أو روابط داخلية جديدة، أو صور داعمة جديدة، أو تجب عن سؤال شائع جديد في كل مرة، لكي تتأكد محركات البحث بكل أشكالها أنك متطور وتقدم أحدث معلومة، مما يعطي انطباعًا لموثوقيتك.

أصلح ملف Robots.txt الذي يمنع زواحف الذكاء الاصطناعي

إذا كنت تريد الظهور في محركات وأدوات الذكاء الاصطناعي، يجب أن تتأكد من أن ملف robots.txt لا يمنع زواحف الذكاء الاصطناعي من زيارة صفحات موقعك التي تريد الاستشهاد بها. من أهمها: GPTBot (OpenAI)، CCBot (Common Crawl)، PerplexityBot، Google-Extended، وClaudeBot. الحل هو أن تضيف أوامر واضحة تسمح لهم بالوصول، مثل:

User-agent: GPTBot

Allow: /

User-agent: *

Disallow:وتتأكد أن لا يوجد Disallow: / عام يغلق الموقع كله. بذلك ستضمن أن محتواك متاح للزحف والاستشهاد به في إجابات الذكاء الاصطناعي، مع إمكانية منع الصفحات الحساسة إن أردت ذلك.

أصلح الصفحات المكسورة

مثلما يتأثر جوجل بالصفحات المكسورة، تتأثر أيضًا زواحف الذكاء الاصطناعي. إذا كانت صفحات خدماتك الأساسية تعطي 404 أو 500 أو تتسبب في انتهاء المهلة أثناء الزحف، فلن تظهر أبدًا في إجابات الذكاء الاصطناعي. المشاكل الشائعة هي أن زواحف الذكاء الاصطناعي تُرى -خطأً- على أنها هجوم DDoS، أو يمنعها الـ CDN/firewall، أو تُفرض عليها قيود معينة. الحل هو أن تضيف زواحف الذكاء الاصطناعي إلى القائمة البيضاء في الـ CDN مثل Cloudflare أو Fastly، وتضبط تتبع السيرفر ليفرق بين الزوار العاديين والزواحف.

تجنب الجافا اسكربت في محتواك الأساسي

معلومة هامة، تعاني معظم زواحف الذكاء الاصطناعي من مشاكل تتعلق بمحتوى الجافا سكربت. حاول تعطيل JavaScript في متصفحك وتحقق من الصفحات المهمة لديك: إذا كانت فارغة، فإن الذكاء الاصطناعي سيعتبرها فارغة أيضًا. الحل يكمن في استخدام تقنية Server-side rendering (مثل Next.js أو Nuxt.js)، أو مولدات المواقع الثابتة (مثل Gatsby أو Hugo)، أو تحسين تدريجي يضمن ظهور المحتوى الأساسي دون الحاجة إلى JavaScript.

كل هذه الاستراتيجيات مهمة وأساسية، ولكني أسلط الضوء على التحسين الفعلي الكامل لموقعك الإلكتروني والتركيز على المحتوى الضعيف وتغطيته بشمولية منفردة، وتأكد أنك ستنال نصيبًا لا بأس به من نتائج الذكاء الاصطناعي.