ما هو التعلم العميق ، وكيف يعمل ، وما هي أكثر تطبيقاته شيوعًا؟ إليك الدليل الأكثر شمولاً للتعلم العميق للمبتدئين.

هل تساءلت يومًا كيف يمكن لـ Google ترجمة فقرات كاملة من لغة إلى أخرى في غضون أجزاء من الثانية ؛ كيف يمكن لـ Netflix و YouTube تقديم توصيات جيدة ؛ كيف يمكن حتى السيارات ذاتية القيادة؟

كل هذه الابتكارات هي نتاج التعلم العميق والشبكات العصبية الاصطناعية.

فهرس

فهم التعلم العميق

التعلم العميق هو مجموعة فرعية من التعلم الآلي ، وهو مجموعة فرعية من الذكاء الاصطناعي. الذكاء الاصطناعي هو مصطلح عام يشير إلى التقنيات التي تمكن أجهزة الكمبيوتر من محاكاة السلوك البشري. يمثل التعلم الآلي مجموعة من الخوارزميات المدربة على البيانات التي تجعل كل هذا ممكنًا. التعلم العميق هو مجرد نوع من التعلم الآلي ، مستوحى من بنية الدماغ البشري.

تحاول خوارزميات التعلم العميق استخلاص استنتاجات مماثلة كما يفعل البشر من خلال التحليل المستمر للبيانات بهيكل منطقي معين. لتحقيق ذلك ، يستخدم التعلم العميق بنية متعددة الطبقات من الخوارزميات تسمى الشبكات العصبية.

يعتمد تصميم الشبكة العصبية على بنية الدماغ البشري. مثلما نستخدم أدمغتنا لتحديد الأنماط وتصنيف الأنواع المختلفة من المعلومات ، يمكننا تعليم الشبكات العصبية أداء نفس المهام على البيانات.

يمكن أيضًا اعتبار الطبقات الفردية للشبكات العصبية نوعًا من المرشحات التي تعمل من الإجمالي إلى الدقيق ، مما يزيد من احتمالية اكتشاف النتيجة الصحيحة وإخراجها. يعمل الدماغ البشري بالمثل. كلما تلقينا معلومات جديدة ، يحاول الدماغ مقارنتها بأشياء معروفة. يتم استخدام نفس المفهوم أيضًا من قبل الشبكات العصبية العميقة.

تمكننا الشبكات العصبية من أداء العديد من المهام ، مثل التجميع أو التصنيف أو الانحدار.

باستخدام الشبكات العصبية ، يمكننا تجميع البيانات غير المسماة أو تصنيفها وفقًا لأوجه التشابه بين العينات في البيانات. أو ، في حالة التصنيف ، يمكننا تدريب الشبكة على مجموعة بيانات معنونة من أجل تصنيف العينات في مجموعة البيانات إلى فئات مختلفة.

بشكل عام ، يمكن للشبكات العصبية أداء نفس المهام مثل خوارزميات التعلم الآلي الكلاسيكية (لكن الخوارزميات الكلاسيكية لا يمكنها أداء نفس المهام مثل الشبكات العصبية). بعبارة أخرى ، تتمتع الشبكات العصبية الاصطناعية بقدرات فريدة تمكن نماذج التعلم العميق من حل المهام التي لا يمكن لنماذج التعلم الآلي حلها أبدًا.

جميع التطورات الحديثة في الذكاء الاصطناعي في السنوات الأخيرة ترجع إلى التعلم العميق. بدون التعلم العميق ، لن يكون لدينا سيارات ذاتية القيادة أو روبوتات محادثة أو مساعدين شخصيين مثل Alexa و Siri. ستستمر خدمة الترجمة من Google في كونها بدائية كما كانت قبل 10 سنوات قبل أن تتحول Google إلى الشبكات العصبية ولن يكون لدى Netflix أي فكرة عن الأفلام التي تقترحها. الشبكات العصبية وراء كل هذه التقنيات.

تحدث ثورة صناعية جديدة ، مدفوعة بالشبكات العصبية الاصطناعية والتعلم العميق. في نهاية المطاف ، يعد التعلم العميق هو أفضل وأوضح نهج للذكاء الآلي الحقيقي الذي استخدمناه على الإطلاق.

لماذا يعتبر التعلم العميق شائعًا؟

تعتبر نماذج التعلم العميق أقوى من نماذج التعلم الآلي ولكن لماذا؟

لا يوجد استخراج الميزة

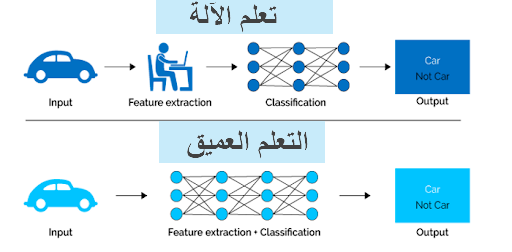

الميزة الأولى التي تميز التعلم العميق عن التعلم الآلي هي تكرار ما يسمى باستخراج الميزات.

قبل وقت طويل من بدء استخدام التعلم العميق ، اعتمدنا على أساليب التعلم الآلي التقليدية بما في ذلك أشجار القرار ، و SVM ، ومصنف Bayes ، والانحدار اللوجستي. تسمى هذه الخوارزميات أيضًا الخوارزميات المسطحة. تشير كلمة “مسطح” هنا إلى حقيقة أن هذه الخوارزميات لا يمكن عادةً تطبيقها مباشرة على البيانات الأولية (مثل .csv ، والصور ، والنص ، وما إلى ذلك). نحتاج إلى خطوة معالجة مسبقة تسمى استخراج الميزة.

نتيجة استخراج الميزة هي تمثيل للبيانات الأولية المحددة التي يمكن أن تستخدمها خوارزميات التعلم الآلي الكلاسيكية هذه لأداء مهمة. على سبيل المثال ، يمكننا الآن تصنيف البيانات إلى عدة فئات أو فئات. عادة ما يكون استخراج الميزة معقدًا للغاية ويتطلب معرفة مفصلة بمجال المشكلة. يجب تكييف طبقة المعالجة المسبقة هذه واختبارها وصقلها عبر عدة تكرارات للحصول على أفضل النتائج.

لا تحتاج الشبكات العصبية الاصطناعية في التعلم العميق إلى خطوة استخراج الميزة. الطبقات قادرة على تعلم تمثيل ضمني للبيانات الخام مباشرة ومن تلقاء نفسها.

وإليك كيفية عملها: يتم إنتاج المزيد والمزيد من التمثيل المجرد والمضغوط للبيانات الأولية عبر عدة طبقات من الشبكة العصبية الاصطناعية. ثم نستخدم هذا التمثيل المضغوط لبيانات الإدخال للحصول على النتيجة. يمكن أن تكون النتيجة ، على سبيل المثال ، تصنيف بيانات الإدخال إلى فئات مختلفة.

بمعنى آخر ، يمكننا القول أن خطوة استخراج الميزة هي بالفعل جزء من العملية التي تحدث في شبكة عصبية اصطناعية.

أثناء عملية التدريب ، تعمل هذه الشبكة العصبية على تحسين هذه الخطوة للحصول على أفضل تمثيل تجريدي ممكن لبيانات الإدخال. هذا يعني أن نماذج التعلم العميق تتطلب القليل من الجهد اليدوي أو لا تتطلب أي جهد يدوي لأداء عملية استخراج الميزات وتحسينها.

دعونا نلقي نظرة على مثال ملموس. إذا كنت ترغب في استخدام نموذج التعلم الآلي لتحديد ما إذا كانت صورة معينة تظهر سيارة أم لا ، فنحن البشر نحتاج أولاً إلى تحديد الميزات الفريدة للسيارة (الشكل والحجم والنوافذ والعجلات وما إلى ذلك) ، ثم استخراج ميزة وإعطائها للخوارزمية كبيانات إدخال. بهذه الطريقة ، تقوم الخوارزمية بتصنيف الصور. بمعنى ، في التعلم الآلي ، يجب أن يتدخل المبرمج مباشرة في الإجراء حتى ينتهي النموذج.

في حالة نموذج التعلم العميق ، تكون خطوة استخراج الميزة غير ضرورية تمامًا. سوف يتعرف النموذج على هذه الخصائص الفريدة للسيارة ويقوم بعمل تنبؤات صحيحة دون تدخل بشري.

في الواقع ، فإن الامتناع عن استخراج خصائص البيانات ينطبق على كل مهمة أخرى تقوم بها مع الشبكات العصبية. ببساطة أعط البيانات الأولية للشبكة العصبية وسيقوم النموذج بالباقي.

عصر البيانات الضخمة

الميزة الضخمة الثانية للتعلم العميق ، والجزء الرئيسي لفهم سبب انتشاره بشكل كبير ، هو أنه مدعوم بكميات هائلة من البيانات. سيوفر عصر البيانات الضخمة فرصًا هائلة لابتكارات جديدة في التعلم العميق. لكن لا تأخذ كلامي على هذا النحو ، يقول أندرو نج ، كبير العلماء في محرك البحث الرئيسي في الصين بايدو ، والمؤسس المشارك لشركة كورسيرا وأحد قادة مشروع Google Brain ، على النحو التالي:

أعتقد أن الذكاء الاصطناعي يشبه بناء سفينة الصواريخ. أنت بحاجة إلى محرك ضخم وكثير من الوقود. إذا كان لديك محرك كبير وكمية ضئيلة من الوقود ، فلن تصل إلى المدار. إذا كان لديك محرك صغير وطن من الوقود ، فلا يمكنك حتى الإقلاع. لبناء صاروخ تحتاج إلى محرك ضخم وكثير من الوقود. الشبيه بالتعلم العميق هو أن محرك الصاروخ هو نماذج التعلم العميق والوقود هو الكميات الهائلة من البيانات التي يمكننا تزويد هذه الخوارزميات بها.

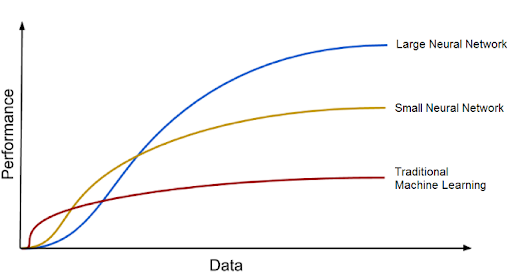

تميل نماذج التعلم العميق إلى زيادة دقتها مع زيادة كمية بيانات التدريب ، بينما تتوقف نماذج التعلم الآلي التقليدية مثل SVM ومصنف Bayes الساذج عن التحسن بعد نقطة التشبع.

كيف تعمل الشبكات العصبية للتعلم العميق

الشبكات العصبية البيولوجية

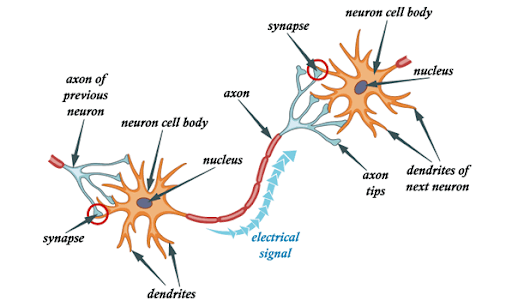

الشبكات العصبية الاصطناعية مستوحاة من الخلايا العصبية البيولوجية الموجودة في أدمغتنا. في الواقع ، تحاكي الشبكات العصبية الاصطناعية بعض الوظائف الأساسية للشبكة العصبية البيولوجية ، ولكن بطريقة مبسطة للغاية. دعونا نلقي نظرة أولاً على الشبكات العصبية البيولوجية لاشتقاق أوجه التشابه مع الشبكات العصبية الاصطناعية.

باختصار ، تتكون الشبكة العصبية البيولوجية من العديد من الخلايا العصبية.

تتكون الخلية العصبية النموذجية من جسم الخلية والتشعبات والمحور العصبي. التشعبات هي هياكل رقيقة تنبثق من جسم الخلية. المحور العصبي هو امتداد خلوي ينبثق من جسم الخلية هذا. تتلقى معظم الخلايا العصبية إشارات من خلال التشعبات وترسل إشارات على طول المحور العصبي.

في غالبية نقاط الاشتباك العصبي ، تعبر الإشارات من محور عصبون إلى تغصن آخر. جميع الخلايا العصبية قابلة للإثارة كهربائيًا بسبب الحفاظ على تدرجات الجهد في أغشيتها. إذا تغير الجهد بمقدار كبير بما يكفي خلال فترة زمنية قصيرة ، فإن العصبون يولد نبضة كهروكيميائية تسمى جهد الفعل. ينتقل هذا الجهد بسرعة على طول المحور العصبي وينشط الاتصالات المشبكية.

الشبكات العصبية الاصطناعية

الآن بعد أن أصبح لدينا فهم أساسي لكيفية عمل الشبكات العصبية البيولوجية ، دعنا نلقي نظرة على بنية الشبكة العصبية الاصطناعية.

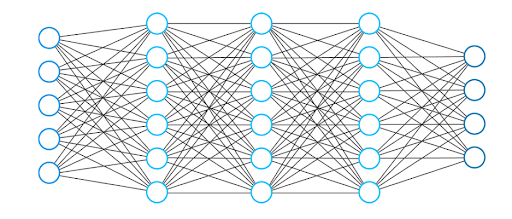

تتكون الشبكة العصبية بشكل عام من مجموعة من الوحدات أو العقد المتصلة. نسمي هذه العقد الخلايا العصبية. تعمل هذه الخلايا العصبية الاصطناعية بشكل فضفاض على تشكيل الخلايا العصبية البيولوجية لدماغنا.

الخلايا العصبية هي ببساطة تمثيل رسومي لقيمة رقمية (على سبيل المثال 1.2 ، 5.0 ، 42.0 ، 0.25 ، إلخ). يمكن اعتبار أي اتصال بين اثنين من الخلايا العصبية الاصطناعية بمثابة محور عصبي في دماغ بيولوجي. تتحقق الروابط بين الخلايا العصبية من خلال ما يسمى بالأوزان ، والتي هي أيضًا ليست أكثر من قيم عددية.

عندما تتعلم الشبكة العصبية الاصطناعية ، تتغير الأوزان بين الخلايا العصبية ، وكذلك قوة الاتصال. حسنا، ماذا يعني ذلك؟ بالنظر إلى بيانات التدريب ومهمة معينة مثل تصنيف الأرقام ، فإننا نبحث عن مجموعة أوزان معينة تسمح للشبكة العصبية بأداء التصنيف.

تختلف مجموعة الأوزان لكل مهمة وكل مجموعة بيانات. لا يمكننا التنبؤ بقيم هذه الأوزان مسبقًا ، لكن على الشبكة العصبية أن تتعلمها. عملية التعلم هي ما نسميه التدريب.

بنية الشبكة العصبية للتعلم العميق

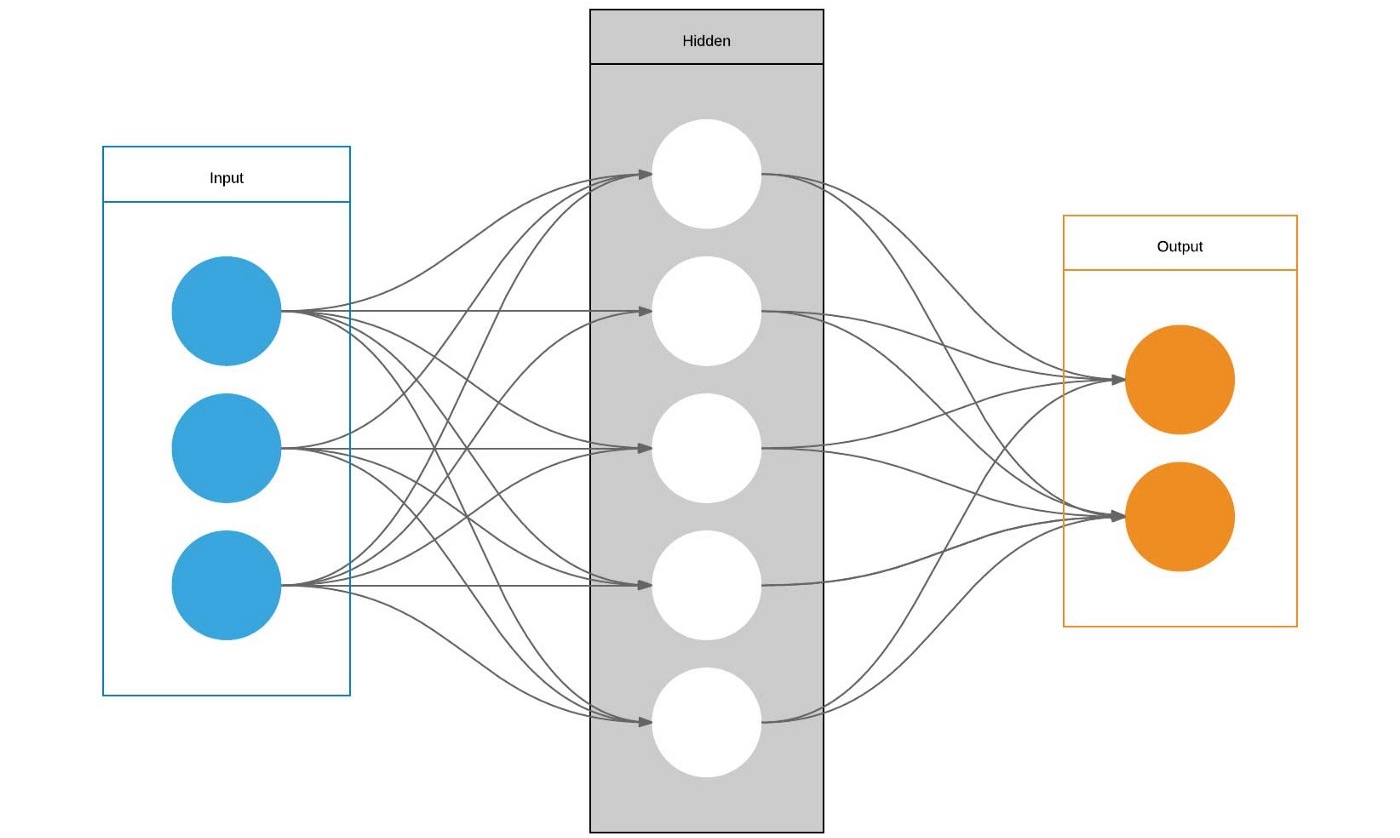

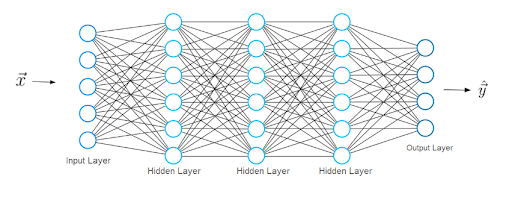

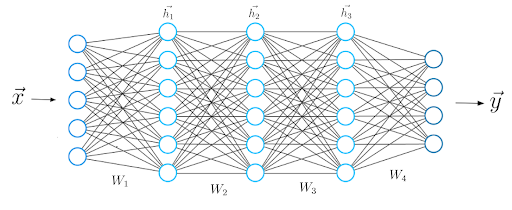

تتكون بنية الشبكة العصبية النموذجية من عدة طبقات ؛ نسمي الطبقة الأولى طبقة الإدخال.

تتلقى طبقة الإدخال لــــإدخال x ، (أي البيانات التي تتعلم منها الشبكة العصبية). في مثالنا السابق لتصنيف الأرقام المكتوبة بخط اليد ، تمثل هذه المدخلات x صور هذه الأرقام (x هو في الأساس متجه كامل حيث يكون كل إدخال بكسل).

تحتوي طبقة الإدخال على نفس عدد الخلايا العصبية حيث توجد إدخالات في المتجه x. بعبارة أخرى ، تمثل كل خلية عصبية إدخال عنصرًا واحدًا في المتجه.

تسمى الطبقة الأخيرة طبقة المخرجات ، والتي تنتج متجه y يمثل نتيجة الشبكة العصبية. تمثل المدخلات في هذا المتجه قيم الخلايا العصبية في طبقة الإخراج. في تصنيفنا ، تمثل كل خلية عصبية في الطبقة الأخيرة فئة مختلفة.

في هذه الحالة ، تعطي قيمة الخلية العصبية المخرجة احتمال أن يكون الرقم المكتوب بخط اليد المعطى بواسطة السمات x ينتمي إلى إحدى الفئات الممكنة (أحد الأرقام من 0 إلى 9). كما يمكنك أن تتخيل ، يجب أن يكون عدد الخلايا العصبية الناتجة هو نفس عدد الفئات.

من أجل الحصول على متجه التنبؤ y ، يجب على الشبكة إجراء عمليات حسابية معينة ، والتي تقوم بها في الطبقات بين طبقات الإدخال والإخراج. نسمي هذه الطبقات المخفية. الآن دعونا نناقش كيف تبدو الروابط بين الطبقات.

اتصالات الطبقة في شبكة عصبية التعلم العميق

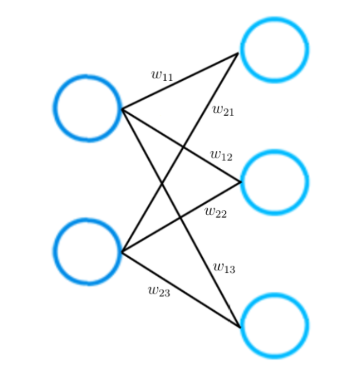

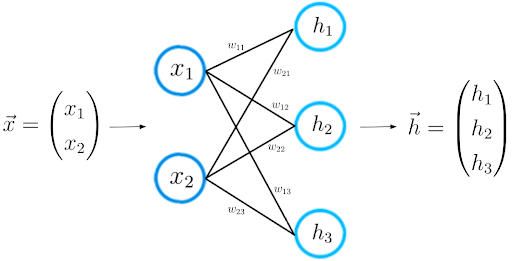

لا تنس أن شبكة عصبية أصغر تتكون من طبقتين فقط. تحتوي طبقة الإدخال على اثنين من الخلايا العصبية المدخلة ، بينما تتكون طبقة الإخراج من ثلاث خلايا عصبية.

كما ذكرنا سابقًا ، يتم تمثيل كل اتصال بين اثنين من الخلايا العصبية بقيمة عددية نسميها بالوزن.

كما ترى في الصورة ، يتم تمثيل كل اتصال بين خليتين بوزن مختلف w. كل وزن ث له مؤشرات. تشير القيمة الأولى للمؤشرات إلى عدد الخلايا العصبية في الطبقة التي ينشأ منها الاتصال ، والقيمة الثانية لعدد الخلايا العصبية في الطبقة التي يؤدي إليها الاتصال.

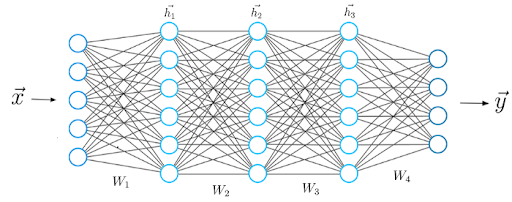

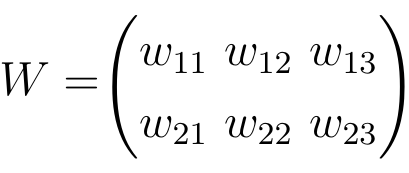

يمكن تمثيل جميع الأوزان بين طبقتين من الشبكة العصبية بمصفوفة تسمى مصفوفة الوزن.

تحتوي مصفوفة الوزن على نفس عدد الإدخالات مثل الروابط بين الخلايا العصبية. تنتج أبعاد مصفوفة الوزن من أحجام الطبقتين المتصلتين بمصفوفة الوزن هذه.

يتوافق عدد الصفوف مع عدد الخلايا العصبية في الطبقة التي تنشأ منها الاتصالات ويتوافق عدد الأعمدة مع عدد الخلايا العصبية في الطبقة التي تؤدي إليها الاتصالات.

في هذا المثال بالذات ، يتوافق عدد صفوف مصفوفة الوزن مع حجم طبقة الإدخال ، وهي اثنان ، وعدد الأعمدة إلى حجم طبقة الإخراج ، وهو ثلاثة.

تعلم عملية التعلم العميق للشبكة العصبية

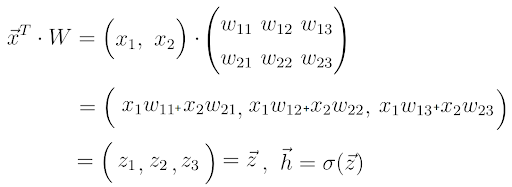

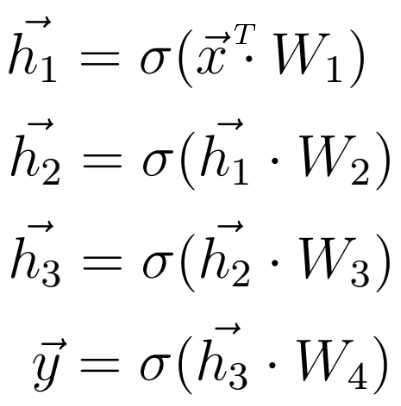

الآن بعد أن فهمنا بنية الشبكة العصبية بشكل أفضل ، يمكننا دراسة عملية التعلم بشكل أفضل. دعونا نفعل ذلك خطوة بخطوة. أنت تعرف بالفعل الخطوة الأولى. بالنسبة لمتجه ميزة الإدخال المحدد x ، تحسب الشبكة العصبية متجه التنبؤ ، والذي نسميه h.

كما نسمي هذه الخطوة إلى الأمام بالانتشار. باستخدام متجه الإدخال x ومصفوفة الوزن W التي تربط بين طبقتين من الخلايا العصبية ، نحسب حاصل الضرب النقطي بين المتجه x والمصفوفة W.

نتيجة حاصل الضرب النقطي هذا هو متجه آخر نسميه z.

نحصل على متجه التنبؤ النهائي h من خلال تطبيق ما يسمى بوظيفة التنشيط على المتجه z. في هذه الحالة ، يتم تمثيل وظيفة التنشيط بحرف سيجما.

وظيفة التنشيط ليست سوى وظيفة غير خطية تقوم بإجراء تخطيط غير خطي من z إلى h.

هناك ثلاث وظائف تنشيط نستخدمها في التعلم العميق: tanh و sigmoid و ReLu.

في هذه المرحلة ، قد تتعرف على المعنى الكامن وراء الخلايا العصبية في الشبكة العصبية: مجرد تمثيل لقيمة رقمية. دعونا نلقي نظرة فاحصة على المتجه z للحظة.

كما ترى ، يتكون كل عنصر من عناصر z من متجه الإدخال x. في هذه المرحلة ، يتجلى دور الأوزان بشكل جميل. تتكون قيمة الخلية العصبية في طبقة من مجموعة خطية من قيم الخلايا العصبية للطبقة السابقة مرجحة ببعض القيم الرقمية.

هذه القيم العددية هي الأوزان التي تخبرنا عن مدى قوة ارتباط هذه الخلايا العصبية ببعضها البعض.

أثناء التدريب ، يتم ضبط هذه الأوزان ؛ تصبح بعض الخلايا العصبية أكثر ارتباطًا بينما تصبح بعض الخلايا العصبية أقل ارتباطًا. كما هو الحال في الشبكة العصبية البيولوجية ، فإن التعلم يعني تغيير الوزن. وفقًا لذلك ، تتغير قيم z و h وناقل الإخراج النهائي y مع الأوزان. تجعل بعض الأوزان تنبؤات الشبكة العصبية أقرب إلى متجه الحقيقة الأرضي الفعلي y_hat ؛ الأوزان الأخرى تزيد من المسافة إلى ناقل الحقيقة الأرضي.

الآن بعد أن عرفنا كيف تبدو الحسابات الرياضية بين طبقتين للشبكة العصبية ، يمكننا توسيع معرفتنا إلى بنية أعمق تتكون من خمس طبقات.

كما في السابق ، نحسب حاصل الضرب النقطي بين المدخلات x ومصفوفة الوزن الأولى W1 ، ونطبق وظيفة التنشيط على المتجه الناتج للحصول على أول متجه مخفي h1. نحن الآن نعتبر h1 المدخلات للطبقة الثالثة القادمة. نكرر الإجراء بأكمله من قبل حتى نحصل على الناتج النهائي y:

وظائف الخسارة في التعلم العميق

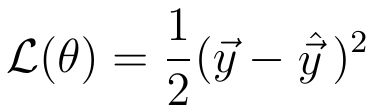

بعد أن نحصل على تنبؤ الشبكة العصبية ، يجب أن نقارن متجه التنبؤ هذا بتسمية الحقيقة الأرضية الفعلية. نحن نسمي ناقلات تسمية الحقيقة الأرضية y_hat.

بينما يحتوي المتجه y على تنبؤات قامت الشبكة العصبية بحسابها أثناء الانتشار الأمامي (والتي قد تكون ، في الواقع ، مختلفة تمامًا عن القيم الفعلية) ، فإن المتجه y_hat يحتوي على القيم الفعلية.

رياضيا ، يمكننا قياس الفرق بين y و y_hat عن طريق تحديد دالة الخسارة ، التي تعتمد قيمتها على هذا الاختلاف.

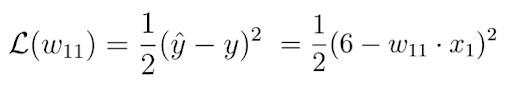

مثال على دالة الخسارة العامة هو الخسارة التربيعية:

تعتمد قيمة دالة الخسارة هذه على الفرق بين y_hat و y. الفرق الأكبر يعني قيمة خسارة أعلى والفرق الأصغر يعني قيمة خسارة أصغر.

يؤدي تقليل وظيفة الخسارة مباشرة إلى تنبؤات أكثر دقة للشبكة العصبية ، حيث يتناقص الفرق بين التنبؤ والتسمية.

يؤدي تقليل وظيفة الخسارة تلقائيًا إلى قيام نموذج الشبكة العصبية بعمل تنبؤات أفضل بغض النظر عن الخصائص الدقيقة للمهمة قيد البحث. ما عليك سوى تحديد وظيفة الخسارة المناسبة للمهمة.

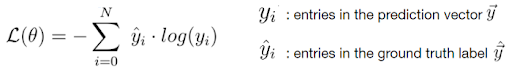

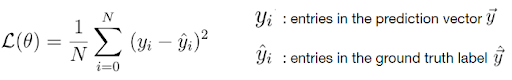

لحسن الحظ ، هناك وظيفتان فقط للخسارة يجب أن تعرفهما لحل أي مشكلة تقريبًا تواجهك في الممارسة: خسارة الانتروبيا المتقاطعة وخسارة الخطأ التربيعي المتوسط (MSE).

الخسارة المتقاطعة :

مربع متوسط الخطأ في الفقدان :

نظرًا لأن الخسارة تعتمد على الوزن ، يجب أن نجد مجموعة معينة من الأوزان تكون فيها قيمة دالة الخسارة صغيرة قدر الإمكان. يتم تحقيق طريقة تقليل دالة الخسارة رياضياً من خلال طريقة تسمى نزول التدرج.

الانحدار المتدرج في التعلم العميق

أثناء نزول التدرج ، نستخدم التدرج اللوني لوظيفة الخسارة (المشتق ، بمعنى آخر) لتحسين أوزان الشبكة العصبية.

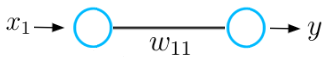

لفهم المفهوم الأساسي لعملية نزول التدرج اللوني ، دعنا نفكر في مثال أساسي لشبكة عصبية تتكون من إدخال واحد وخرج عصبي واحد متصل بقيمة وزن w.

تستقبل هذه الشبكة العصبية مدخلات x وتخرج توقع y. لنفترض أن قيمة الوزن الأولية لهذه الشبكة العصبية هي 5 والمدخل x هو 2. لذلك فإن التنبؤ y لهذه الشبكة له قيمة 10 ، بينما قد يكون للتسمية y_hat قيمة 6.

هذا يعني أن التنبؤ ليس دقيقًا ويجب علينا استخدام طريقة الانحدار لإيجاد قيمة وزن جديدة تجعل الشبكة العصبية تقوم بالتنبؤ الصحيح. في الخطوة الأولى ، يجب أن نختار دالة خسارة للمهمة.

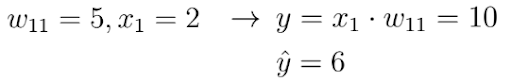

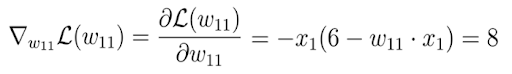

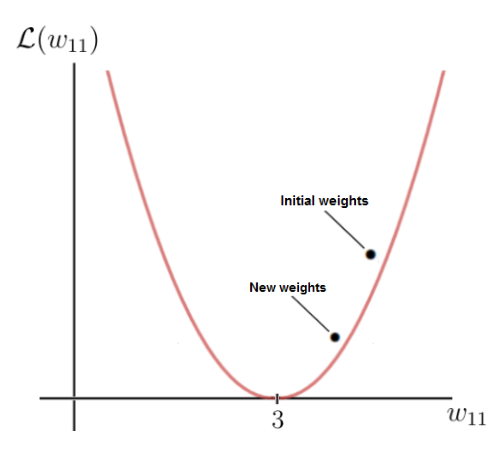

لنأخذ الخسارة التربيعية التي حددتها أعلاه ونرسم هذه الوظيفة ، والتي هي في الأساس مجرد وظيفة تربيعية:

المحور y هو قيمة الخسارة ، والتي تعتمد على الاختلاف بين التسمية والتنبؤ ، وبالتالي معلمات الشبكة – في هذه الحالة ، الوزن الواحد w. يمثل المحور x قيم هذا الوزن.

كما ترون ، هناك وزن معين w تصل فيه وظيفة الخسارة إلى الحد الأدنى العالمي. هذه القيمة هي معلمة الوزن الأمثل التي من شأنها أن تجعل الشبكة العصبية تقوم بالتنبؤ الصحيح (وهو 6). في هذه الحالة ، تكون قيمة الوزن الأمثل 3:

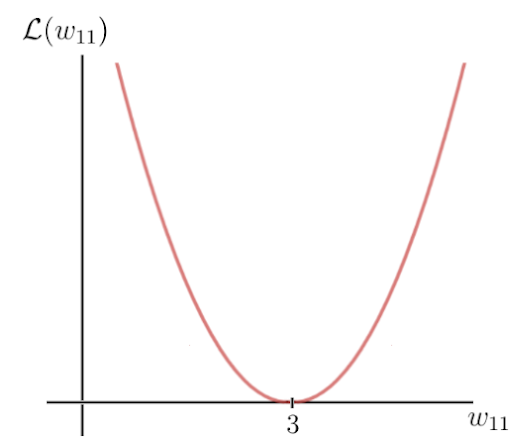

من ناحية أخرى ، فإن وزننا الأولي هو 5 ، مما يؤدي إلى خسارة كبيرة إلى حد ما. الهدف الآن هو تحديث معلمة الوزن بشكل متكرر حتى نصل إلى القيمة المثلى لذلك الوزن المحدد. هذا هو الوقت الذي نحتاج فيه إلى استخدام تدرج دالة الخسارة.

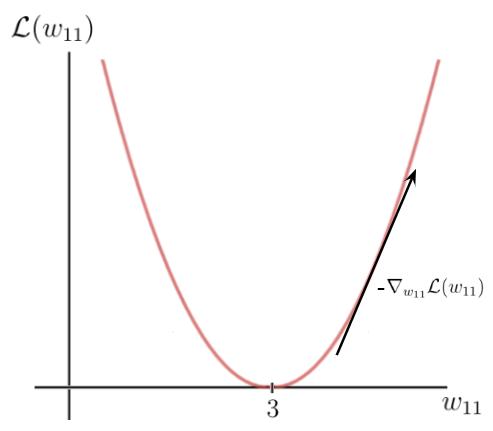

لحسن الحظ ، في هذه الحالة ، تكون دالة الخسارة دالة لمتغير واحد ، الوزن w:

في الخطوة التالية ، نحسب مشتق دالة الخسارة فيما يتعلق بهذه المعلمة:

في النهاية ، نحصل على 8 ، وهو ما يعطينا قيمة ميل أو ظل دالة الخسارة للنقطة المقابلة على المحور x ، وعند هذه النقطة يكمن وزننا الأولي.

يشير هذا الظل إلى أعلى معدل لزيادة دالة الخسارة ومعاملات الوزن المقابلة على المحور x.

هذا يعني أننا استخدمنا للتو التدرج اللوني لوظيفة الخسارة لمعرفة معلمات الوزن التي ستؤدي إلى قيمة خسارة أعلى. ما نريد معرفته حقًا هو العكس تمامًا. يمكننا الحصول على ما نريد إذا ضربنا التدرج في -1 ، وبهذه الطريقة نحصل على الاتجاه المعاكس للانحدار.

هذه هي الطريقة التي نحصل بها على اتجاه أعلى معدل انخفاض لوظيفة الخسارة والمعلمات المقابلة على المحور x والتي تسبب هذا الانخفاض:

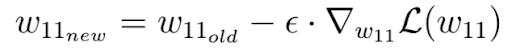

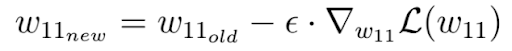

أخيرًا ، نقوم بخطوة نزول متدرج واحدة كمحاولة لتحسين أوزاننا. نستخدم هذا التدرج اللوني السالب لتحديث وزنك الحالي في اتجاه الأوزان التي تتناقص فيها قيمة دالة الخسارة ، وفقًا للتدرج اللوني السالب:

عامل إبسيلون في هذه المعادلة هو معلمة مفرطة تسمى معدل التعلم. يحدد معدل التعلم مدى السرعة أو البطء الذي تريد تحديث المعلمات.

يرجى أن تضع في اعتبارك أن معدل التعلم هو العامل الذي يجب أن نضرب به التدرج السلبي وأن معدل التعلم عادة ما يكون صغيرًا جدًا. في حالتنا ، معدل التعلم هو 0.1.

كما ترى ، فإن وزننا بعد الانحدار المتدرج أصبح الآن 4.2 وأقرب إلى الوزن الأمثل مما كان عليه قبل خطوة التدرج اللوني.

قيمة دالة الخسارة لقيمة الوزن الجديدة أصغر أيضًا ، مما يعني أن الشبكة العصبية قادرة الآن على تقديم تنبؤات أفضل. يمكنك إجراء العملية الحسابية في رأسك ومعرفة أن التنبؤ الجديد هو في الواقع أقرب إلى التسمية من ذي قبل.

في كل مرة نقوم فيها بتحديث الأوزان ، ننتقل إلى التدرج السلبي نحو الأوزان المثلى.

بعد كل خطوة نزول متدرج أو تحديث للوزن ، تقترب الأوزان الحالية للشبكة أكثر فأكثر من الأوزان المثلى حتى نصل إليها في النهاية. في هذه المرحلة ، ستكون الشبكة العصبية قادرة على عمل التنبؤات التي نريد القيام بها.

تأثير التعلم العميق على المجتمع

كتقنية جديدة ، يثير التعلم العميق أسئلة حول استخدامها. هم من أوامر مختلفة. بالطبع ، يمكن أن يؤدي استخدام طريقة الذكاء الاصطناعي هذه إلى مشاكل أخلاقية. سيحدد رصيد قواعد بيانات التدريب نتيجة الخوارزمية. عندما يتعلق الأمر بالبيانات المتعلقة بشركاتنا ، فمن الضروري ضمان التمثيل الجيد لهذه الشركة لتجنب التحيز (العمر والجنس ولون البشرة وما إلى ذلك).

هذا سؤال حساس بقدر ما هذا المجتمع نفسه في التطور. يتعلق جانب أخلاقي آخر بإمكانية تفسير القرارات التي تتخذها الخوارزميات. ينتج هذا القرار عن مرور المعلومات عبر الشبكة في مساحات ذات بعد يتجاوز فهمنا ولا يتم التعبير عنه بطريقة دلالية.

هذا يمثل مشكلة خاصة للتطبيقات في المجال الطبي أو حتى بالنسبة لمسائل العدالة التي تتطلب التبرير وعدم اليقين المعبر عنه بمصطلحات مفهومة من قبل البشر. لذلك فإن التفسير هو موضوع بحثي حديث للغاية في الذكاء الاصطناعي.

يثير استخدام الذكاء الاصطناعي العديد من المناقشات الأخرى حول القضايا الأخلاقية. يتعلق التأثير المجتمعي للذكاء الاصطناعي أيضًا بمسألة التوظيف. تتعرض بعض الوظائف للتهديد من خلال الأداء البشري الخارق للخوارزميات مثل تلك القائمة على التعلم العميق. يشير مؤيدو هذه الخوارزميات المحنكين بالتكنولوجيا إلى أنه يتم إنشاء وظائف جديدة لـ “عالم البيانات” لتطوير هذه الخوارزميات بدقة.

هناك جانب تمت مناقشته قليلاً وهو أن مستوى التأهيل لتطوير هذه الخوارزميات ليس بالضرورة مرتفعًا جدًا. في الواقع ، رموز خوارزميات التعلم العميق متاحة على نطاق واسع. لذلك يتكون عمل عالم البيانات بشكل أساسي من شرح البيانات وتعديل المعلمات الفائقة. يتم تقليل وقت التطوير بشكل كبير مقارنة بالطرق التقليدية حيث تمت برمجة الخوارزمية.

وبالتالي يمكن الحصول على حل برمجي في أقل من أسبوع حيث استغرق الأمر أكثر من عام في أوائل العقد الأول من القرن الحادي والعشرين.حتى أن بعض أعمال التعليقات التوضيحية للبيانات يتم تنفيذها على منصات التعليقات التوضيحية على الإنترنت والتي تحشد الجيوش بأيد صغيرة مقابل مبالغ زهيدة. لذلك فإن التعلم غير الخاضع للإشراف هو موضوع بحث حديث للغاية في مجال الذكاء الاصطناعي.

الجانب الأخير ، الذي لم يتم الإعلان عنه كثيرًا ، هو استهلاك الطاقة لأساليب الذكاء الاصطناعي هذه. من المعروف الآن أن تخزين البيانات في مراكز البيانات يمثل جزءًا مهمًا (أكبر من الطيران المدني على سبيل المثال) من مساهمة النشاط البشري في تأثير الاحتباس الحراري.

طرق التعلم العميق ، كما هو موضح ، كثيفة البيانات هي أيضًا كثيفة الاستهلاك للطاقة. تتطلب موازاة خطوات الالتواء بواسطة مكونات نوع بطاقة الرسومات. لذلك ، فإن البحث عن بنى شبكات عصبية جديدة أكثر مسؤولية تجاه البيئة هو موضوع بحث حديث للغاية في الذكاء الاصطناعي.

أنظر أيضاً:

فوائد التعلم العميق

بالمقارنة مع الهياكل الخوارزمية الأخرى ، تتمتع الشبكات العصبية بميزتين رئيسيتين:

أولاً ، هيكلها القائم على تكديس الوظائف غير الخطية يمنحها سعة هائلة. لقد ثبت أن الشبكة ذات الطبقتين فقط يمكن أن تمثل أي دالة رياضية تربط المدخلات والمخرجات. ومع ذلك ، لأسباب تتعلق بالتدريب والقدرة على الحوسبة ، تشتمل البنى الحديثة على عدد أكبر من الطبقات.

ثانيًا ، تعمل الشبكات كخوارزميات التصنيف ومستخلصات الميزات. في الواقع ، في الغالبية العظمى من الحالات ، يتم توفير البيانات نفسها (قيم البكسل في حالة الصور) كمدخلات لشبكة وليست خصائص محددة مسبقًا.

تتيح خوارزميات الانتشار العكسي والتحسين إمكانية استغلال السعة الكبيرة للشبكة عن طريق تقييد أوزان الشبكات بمجموعة من القيم التي تؤدي إلى أداء تصنيف جيد: يتم تعلم الخصائص على وجه التحديد للمهمة قيد النظر. الخصائص المستخرجة ، بسيطة إذا تم أخذها في الاعتبار في الطبقات الأولى ، تصبح تدريجياً أكثر تعقيدًا من العمليات التي تقوم بها الطبقات.

هذا هو البعد من الطبقات المكدسة ، الذي يسمح بإنشاء ميزات معقدة ، والتي نشير إليها عندما نتحدث عن التعلم “العميق”. يؤدي هذا إلى ميزات يمكن أن تكون دقيقة ودقيقة للغاية ، أكثر بكثير مما يمكن أن تحققه خوارزمية استخراج ميزة بشرية أو نموذجية.